Après la FM, le DAB+

On voit fleurir le sigle « DAB+ » dans les journaux et sur les réseaux. Si, ces dernières années, vous avez loué une voiture dans les pays nordiques ou même en Belgique ou en Angleterre, vous vous êtes peut-être interrogés sur la signification de la touche DAB + de votre autoradio. D’après Wikipédia, le DAB+ est un :« système offrant une meilleure qualité du son et stabilité de la réception, plus de stations qu’en FM, synchronisation de la radio avec d’autres médias (textes, images), des coûts de diffusion moindre grâce à la mutualisation des moyens techniques, … ». Vous n’êtes pas beaucoup plus avancés, mais on va tenter de vous éclairer.

Un peu d’histoire

Les débuts de la radio, c’est un son qui module l’amplitude d’une onde, on parle de diffusion en grandes ondes, en ondes moyennes, en ondes courtes … et cela jusqu’à la fin de la deuxième guerre mondiale. La bande est vite saturée et dès les années 50 apparait une autre technologie, la FM ; cette fois, le son module la fréquence de l’onde. La ‘bande FM’ est « libérée » en France en 1981, conduisant à l’explosion de ce qu’on appelle alors « les radios libres » et à nouveau à une saturation rapide des fréquences notamment dans les grandes agglomérations. Mais les années 80, c’est aussi le début de la maîtrise des technologies numériques dans les laboratoires de recherche.

40 ans après le démarrage de la FM, en 1986, les acteurs de l’industrie européenne de la radio décident donc de développer une technologie de diffusion entièrement numérique : le DAB (Digital Audio Broadcasting), dans une bande de fréquence qui lui serait réservée.

Cette intention se concrétise en 1987 par la création du projet de recherche européen Eureka-DAB, aux résultats particulièrement fructueux. Le projet aboutit :

- à la genèse de la compression audio MPEG, qui évoluera ensuite vers le fameux MP3 !

- au développement de la technologie de transmission COFDM (Coded Orthogonal Frequency Division Multiplexing), sur la base des propositions techniques issues des travaux du CCETT ( Centre Commun d’Étude de Télécommunication et Télédiffusion)

Transmettre en numérique est une gageure

La diffusion numérique doit assurer une réception de qualité dans des conditions radio souvent difficiles car, au contraire de la télévision, les récepteurs fonctionnent sans antenne directive. Au niveau des rues, la réception des ondes par les autoradios est masquée par les immeubles et les tunnels ; à la maison, la propagation du signal est perturbée par les murs et les immeubles voisins.

Par ailleurs, Le débit numérique du son stéréo du CD audio [LFBT1] est d’environ 1,4 Mégabit par seconde, équivalent à celui d’une vidéo comprimée de la TNT. Dans de telles conditions, un son de qualité CD transmis tel quel occuperait une bande passante de plus d’1,5 Mégahertz, impensable dans le contexte de rareté des fréquences d’autant qu’en FM les radios sont espacées de 400 kilohertz.

Le projet DAB a donc développé :

- un procédé de transmission spécifique qui s’affranchit des aléas de la propagation : masquage des signaux, échos, brouillage, réception au niveau du sol à des vitesses qui peuvent dépasser les 100 kms/heure.

- des techniques de compression du son, soumises à la normalisation internationale ISO-MPEG, qui seront par la suite utilisées pour de nombreuses autres applications

Comprimer oui mais sans dégrader

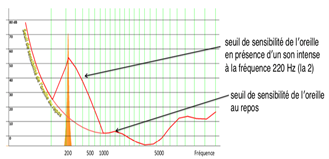

Le principe repose sur les propriétés de l’audition. À une fréquence donnée, la présence d’une composante forte relève considérablement le seuil de sensibilité de l’oreille au voisinage de cette fréquence : il y a masquage d’éventuels autres signaux plus faibles. Il est donc possible de coder cette composante avec une faible précision, car le bruit qui en résulte restera masqué à proximité de la fréquence concernée.

On découpe donc le son à coder en tranches de quelques dizaines de millisecondes. Dans chaque tranche, on calcule son spectre et on le découpe en une trentaine de « sous-bandes » de fréquences. À l’intérieur de chacune un modèle psycho-acoustique permet de ne coder son contenu qu’avec la précision nécessaire compte tenu du masquage apporté par les composantes présentes. Au décodage, on effectue la transformation inverse fréquence vers temps et le signal est restitué. Il y a perte d’information, d’autant plus importante que la compression est plus forte, mais on peut adapter le compromis entre qualité et débit résultant en ajustant le paramètre de tolérance dans le calcul du masquage. Les tests ont démontré que l’on peut rendre la dégradation indécelable tout en ayant réduit fortement le débit.

Quant à diffuser, c’est une autre histoire…I

Il est peu judicieux d’utiliser une fréquence pour une seule station radio, car cela imposerait de définir un signal figé, à débit fixe, pour diffuser une source sonore dont le débit ne manquerait de décroitre avec l’amélioration du codage.

Par ailleurs, il est intéressant de regrouper plusieurs stations radio dans le même signal pour mutualiser les coûts de diffusion : en cassant le paradigme ‘une radio, un signal, un émetteur’, un seul émetteur de puissance alimentant une seule antenne peut diffuser plusieurs radios.

Et enfin, si on ajoute que plus on utilise une bande de fréquence importante pour transmettre un signal dans des conditions de propagation difficiles, mieux on sait assurer la qualité de la transmission ; pour peu que la bande soit suffisamment large, toutes ses fréquences ne se comportent pas de la même manière, et on sait en tirer parti.

La propagation des ondes vers les récepteurs est affectée par les échos provenant des réflexions du signal sur les différents obstacles, immeubles, relief, et ces échos se modifient en permanence en réception mobile. Les échos ont pour effet de détruire partiellement des portions du signal et d’en renforcer d’autres. Pour en tirer parti, on transmet les informations numériques en y rajoutant de la redondance et en les entrelaçant, de sorte que les informations liées par la redondance se retrouvent séparées, distribuées sur des portions du signal espacées à la fois en fréquence et dans le temps. En réception, les informations portées par les portions du signal détruites par les échos pourront être reconstruites grâce à la redondance qui les lie à celles transmises sur les portions renforcées du signal. Ce principe est d’autant plus efficace que la largeur de bande du signal est importante, ce qui justifie de regrouper plusieurs radios pour former un signal unique, sur une largeur de bande d’environ 1,5 Mégahertz, bon compromis qui garantit une gestion simple du spectre des fréquences. Grâce à ce regroupement, chaque station radio contribue à la bonne réception de toutes les stations qui partagent le même signal DAB+ !

Ces techniques constituent les fondements du système dit ‘COFDM’ pour Coded Orthogonal Frequency Division Multiplex.

Une collaboration industrielle exemplaire a permis l’adoption dès le début des années 90 de la norme européenne DAB, qui a bénéficié bien plus tard de quelques évolutions en prenant la dénomination DAB+ : alors que les principes de la transmission n’appelaient pas d’inflexion particulière, il était nécessaire d’y introduire un procédé de codage du son représentant l’état de l’art. Avec le codage issu de la norme MPEG-4, un signal DAB+ porte jusqu’à 13 programmes radio en utilisant une bande de fréquence de 1,5 Mégahertz. Les 28 canaux de fréquence VHF attribués en France offrent donc une ressource confortable pour le déploiement de la radio numérique.

Pourquoi seulement aujourd’hui ?

Le déploiement a donné lieu à un « feuilleton » de plus de trente ans.Que manquait-il au DAB pour passer du laboratoire au récepteur ?

Des fréquences adaptées et une réglementation définitive.

Suite aux accords internationaux, une loi de 2004 fixe les principes d’attribution aux opérateurs des fréquences de la bande III (VHF). Mais celle-ci ne sera disponible qu’en 2010 après sa libération par Canal+.

Une stratégie de déploiement.

Faut-il viser, à l’instar de la TNT, un remplacement rapide de l’analogique par le numérique ou bien envisager que le DAB assure des services complémentaires ? Faut-il donner seulement des autorisations locales ou bien attribuer également des droits à l’échelle nationale ?

Les années passent ; de consultations infructueuses, en multiples rapports et moratoires. Après de nombreux blocages, le CSA propose en 2013 une nouvelle stratégie dite « des arcs et des nœuds », dans laquelle on vise à l’amélioration de la couverture en mobilité des radios existantes (les arcs) complétée par des diffusions locales centrées dans un premier temps sur les grandes métropoles (les nœuds). Deux multiplex sont attribués nationalement pour la couverture des axes. Un calendrier de déploiement est arrêté par le CSA. Les radios privées acceptent la nouvelle stratégie et Radio-France est autorisée à diffuser ses services en numérique. Ce plan est en cours d’exécution.

Le Modèle économique

Il n’est pas simple à trouver : des gains de productivité faible, des améliorations de services par petites touches et surtout un taux de renouvellement des équipements beaucoup plus faible qu’en télévision, donc peu d’intérêt du monde industriel.

La concurrence, elle, ne manque pas ! Car notamment grâce aux travaux sur le son de 1980, la radio est déjà numérique dans les studios et sur internet qui capte aujourd’hui une part croissante de l’écoute. L’innovation qui ne manquera pas de naître des radios nativement numériques tiendra-elle face aux offres de musique des plateformes et aux podcasts natifs. Faut-il compter sur l’attachement aux grands principes d’universalité, de gratuité et d’anonymat pour sanctuariser le media et équilibrer la concurrence de la 4G et de la 5G ?

Dans tous les cas, ce qui était annoncé comme le seul futur de la radio diffusée, ce qui est le cas dans certains pays comme la Norvège et la Suisse, sera un des futurs de la radio, en particulier en France.

Mais on peut déjà identifier de nombreuses retombées des technologies mises au point lors du développement du DAB.

La compression du son tout d’abord qui a pris une dimension économique considérable sous le nom de MP3. Présente aujourd’hui dans toutes les applications contenant du son notamment sur Internet.

Quant à l’OFDM il est sous-jacent aujourd’hui dans de nombreux secteurs ou la transmission du signal est difficile : citons l’ADSL, le CPL, la 4G et demain la 5G.

Pourquoi cet évènement, quel rôle pour le CCETT ?

Dans les années 70 s’installaient en région Rennaise, notamment à Cesson-Sévigné, des entreprises, grandes écoles et laboratoires de recherche majeurs en électronique, audiovisuel et télécommunications. Pendant plus de 50 ans se sont accumulées des compétences multiples et une notoriété internationale rare dans ces domaines.

L’A3C7, l’Association Amicale des Agents du CCETT (aujourd’hui Orange Labs) a l’ambition, modestement, de conserver et de mettre en valeur une partie de ce patrimoine, celle pour laquelle le CCETT a été un acteur ou un partenaire majeur. Dans cet esprit ont déjà été conçu trois évènements, autour de la photographie numérique et de la norme JPEG, du véhicule intelligent et communicant et du programme Carminat, un troisième dédié à la Télévision Numérique.

Fiers d’avoir été un partenaire clé du développement de la Radio Numérique, nous en dévoilons l’histoire, expliquons « comment ça marche » et faisons un point sur le déploiement en France.

C’est rendre hommage aux hommes et femmes engagés dans cette aventure que de montrer comment ces compétences et cette notoriété d’hier sont des atouts majeurs pour le développement économique du territoire aujourd’hui.